AI in cyberbeveiliging is van onschatbare waarde, omdat deze technologie het komende decennium het gezicht van het beveiligingslandschap zal veranderen. Aan de ene kant geeft het je de kracht om proactief te zijn en snel te reageren op digitale bedreigingen en aanvallen. Maar cybercriminelen hebben ook toegang tot deze technologie, waardoor het gemakkelijker wordt om kwaadaardige activiteiten te ontplooien.

Nu deze cruciale technologie zich ontwikkelt en verbetert, is het tijd om er wat dieper op in te gaan. Laten we eens begrijpen hoe de cyberbeveiligingsindustrie deze technologie gebruikt, welke tools er beschikbaar zijn en welke problemen ze opleveren.

Inhoudsopgave

AI-bedreigingen voor cyberveiligheid: 3 manieren waarop cybercriminelen gebruikmaken van deze technologie

Cybercriminelen hebben ook tools in handen die worden aangedreven door kunstmatige intelligentie (AI). Dit geeft ze de middelen om complexe aanvallen uit te voeren. Hieronder staan drie AI-bedreigingen voor cyberbeveiliging waarvan je op de hoogte moet zijn.

1. Geavanceerde technieken voor social engineering

Mensen zijn altijd de zwakste schakel, zelfs als u beschikt over de modernste infrastructuur om cyberaanvallen op te sporen en te voorkomen. Social engineering is een methode om privégegevens te ontfutselen of toegang te krijgen tot beveiligde systemen en netwerken. Cybercriminelen gebruiken deze techniek omdat het hen buitengewoon effectief helpt om hun snode doelen te bereiken.

Slechte acteurs kunnen snel inhoud creëren met behulp van verschillende AI-tools. Vervolgens gebruiken ze deze inhoud om mensen te verleiden dingen te doen die ze normaal niet zouden doen.

Cybercriminelen doen zich bijvoorbeeld voor als de Internal Revenue Service (IRS). Ze kunnen inhoud genereren die er legitiem en formeel uitziet met AI-tools en je vragen om je belasting te betalen. Slechte acteurs kunnen je bellen en nepgeluid gebruiken om je ervan te overtuigen dat je echt met de belastingdienst te maken hebt.

2. Hoogwaardige Deepfakes

Cybercriminelen gebruiken AI deepfakes om talloze cyberbeveiligingsgerelateerde problemen te creëren. Slechte actoren kunnen deze technologie gebruiken om zich voor te doen als hooggeplaatste personen. Het verspreiden van dit soort content is eenvoudig. Bovendien kunnen mensen gemakkelijk aannemen dat deze nepfoto's en -video's echt zijn.

Gewoonlijk gebruiken cybercriminelen deze technologie samen met social engineering-technieken om ervoor te zorgen dat hun aanvallen effectief zijn.

Er zijn ook echte voorbeelden van slechte actoren die deepfakes gebruiken om bedrijven en individuen op te lichten. Zo maakte een multinational 25 miljoen dollar over aan cybercriminelen nadat ze de financieel directeur van de organisatie hadden gefingeerd. Deze personen creëerden neppersona's van echte mensen en gebruikten deze technologie in een videogesprek.

Op dezelfde manier maakte Taylor Swift deel uit van een deepfake-aanval op X. Slechte acteurs maakten nepafbeeldingen van de popster en verspreidden deze op X, nu Twitter.

3. AI-tools targeten met gegevensvergiftigingstechnieken

AI is sterk afhankelijk van de gegevens die je aanlevert om accurate resultaten te produceren. Als er fouten in deze datasets zitten, worden de resultaten onnauwkeurig. Cybercriminelen kunnen de gegevens die deze tools gebruiken vergiftigen om achterdeurtjes te creëren.

Een bedrijf gebruikt bijvoorbeeld een AI-tool om e-mails met spam en schadelijke inhoud te verminderen. Hackers kunnen de gegevens die deze organisatie gebruikt om deze tool te trainen en te verbeteren, vergiftigen. Na verloop van tijd kunnen ze ervoor zorgen dat deze tool e-mails met schadelijke koppelingen toestaat. Hierdoor kunnen de slechte actoren ongeautoriseerde toegang krijgen wanneer een nietsvermoedende werknemer de URL in de e-mail bezoekt.

Hackers kunnen ook datasets vergiftigen om ervoor te zorgen dat AI-tools hen met specifieke aanwijzingen privé-informatie geven.

Hoe kan generatieve AI worden gebruikt in cyberbeveiliging: 3 toepassingen van deze technologie

Generatieve AI kan inhoud maken, zoals video's, audio, afbeeldingen en tekst. Open AI's ChatGPT en Google's Gemini zijn bijvoorbeeld echte voorbeelden van deze technologie. Hoe kan generatieve AI worden gebruikt in cyberbeveiliging?

Hieronder staan drie manieren waarop experts en organisaties deze technologie gebruiken om zichzelf te beveiligen.

1. Verdacht gebruikersgedrag analyseren en ontdekken

Met machine learning-technieken kun je gedragsprofielen maken van de werknemers van je organisatie. Ze vormen de basislijn voor hoe mensen zich zullen gedragen wanneer ze de apparaten van je bedrijf gebruiken.

Met deze modellen kunnen AI-tools op zoek gaan naar uitschieters en deze onder de aandacht brengen van de beveiligingsanalisten van het bedrijf. Deze professionals kunnen dan bedenken hoe ze dit soort cyberaanvallen in de toekomst kunnen voorkomen.

Stel dat je een tool hebt om bots op je website te detecteren. Bots hebben een negatieve invloed op de gebruikerservaring (UX), omdat ze de neiging hebben om de beschikbare bronnen te overweldigen. Mensen kunnen merken dat je website traag laadt of dat andere diensten niet werken.

Door botactiviteiten te bestuderen en te analyseren, kunnen deze tools soortgelijk gedrag detecteren en deze bezoekers onmiddellijk blokkeren.

2. De reactietijd op cyberaanvallen verkorten

Cyberaanvallen gebeuren snel en het kost cyberbeveiligingsteams tijd om te reageren. Hoe sneller deze teams kunnen reageren, hoe beter het is voor de organisatie. AI-beveiligingstools kunnen helpen de reactietijd te verbeteren.

Om te beginnen, wanneer een organisatie lijdt onder een aanval, kan deze technologie relevante gegevens verzamelen en classificeren. Het kan ook rapporten maken en de informatie vereenvoudigen. Cyberbeveiligingsteams kunnen deze rapporten bekijken en begrijpen wat de volgende stap is.

Bedrijven kunnen deze tools gebruiken om de patronen van eerdere aanvallen te bestuderen en hoe ze op deze bedreigingen hebben gereageerd. Na verloop van tijd kan deze technologie de beste handelswijze suggereren als de organisatie wordt getroffen door een soortgelijke cyberaanval.

3. Redenen voor potentiële bedreigingen herkennen

De meeste cyberaanvallen die je tegenkomt gebruiken oudere broncodes en frameworks als basis. Mensen vinden het echter een uitdaging om soortgelijke bedreigingen te detecteren en op tijd te reageren. Dit is waar AI kan helpen de cyberbeveiliging te verbeteren.

Het leert van verschillende aanvalsdatasets en vergelijkt deze met nieuwe bedreigingen om te kijken wat er gemeenschappelijk is tussen de twee. Dit maakt het herkennen van potentiële bedreigingen eenvoudiger en het nemen van de nodige veiligheidsmaatregelen om dergelijke aanvallen te voorkomen.

3 Nadelen van AI in cyberbeveiliging

Hoewel AI veelbelovend is, heeft het ook nadelen. Hieronder staan drie nadelen van AI in cyberbeveiliging.

1. Het is kwetsbaar voor slechte datasets

Datasets zijn het levensbloed van AI-technologieën, omdat ze op deze informatie vertrouwen om betrouwbare beslissingen te nemen. Zoals eerder is benadrukt, is het probleem dat slechte actoren deze gegevens kunnen manipuleren. Ook kunnen AI-tools onbetrouwbare resultaten leveren als je ze de verkeerde datasets geeft.

Dit introduceert vooroordelen en zorgt er ook voor dat valse positieven de norm worden. Een AI-gebaseerde e-mailfiltertool kan er bijvoorbeeld voor zorgen dat mensen geen spammail te zien krijgen in hun dashboards. Maar door slechte gegevens verwijdert het elke e-mail met een link, omdat het aanneemt dat dit bericht spam is. Of het kan medewerkers verkeerd classificeren als slechte actoren, ze uitsluiten van hun systemen en hun tijd verspillen.

2. Het verhoogt de snelheid van evolutie en de snelheid van cyberaanvallen

Cyberbeveiligingsprofessionals hebben al te maken met bedreigingen die zich steeds verder ontwikkelen en geavanceerder worden. Met AI-technologie hebben cybercriminelen de middelen om deze evolutiesnelheid te verhogen. Ze leren nieuwe technieken, zetten complexe aanvallen in en richten zich snel op verschillende organisaties.

AI maakt het moeilijker om je aan te passen aan de steeds veranderende aard van cyberaanvallen. Oudere beveiligingsmaatregelen vallen in de categorie verouderd, dus ontwikkelaars moeten regelmatig nieuwe oplossingen ontwikkelen.

3. Er is nog steeds menselijke intelligentie voor nodig

Hoewel deze technologie ongelooflijk krachtig is, heeft het nog steeds de inbreng van mensen nodig om echt effectief te zijn. Om te beginnen moeten mensen deze tools voorzien van de benodigde datasets. Ook moeten mensen elk probleem dat ze tegenkomen bij het gebruik van deze technologie tot op de bodem uitzoeken.

Als mensen zelfgenoegzaam worden, kunnen deze tools na verloop van tijd ook ineffectief worden. Om te beginnen zorgen slechte datasets voor vertekeningen in de uitvoer, waardoor de resultaten onnauwkeurig worden. En als mensen de fouten niet opsporen en corrigeren, zal de technologie dezelfde fouten blijven maken.

2 AI-gebaseerde tools voor cyberbeveiliging die u vandaag moet gebruiken

Het integreren van AI-gebaseerde cyberbeveiligingstools in je bestaande infrastructuur is essentieel om jezelf veilig te houden. Hieronder vindt u een lijst met twee effectieve tools die u zou moeten gebruiken.

1. Vectra AI

Vectra AI is een betrouwbare cyberbeveiligingstool die gebruikmaakt van AI. Het is eenvoudig om deze technologie te integreren met je bestaande framework. Deze tool kent scores toe aan verschillende bedreigingsvectoren om je te helpen prioriteiten te stellen en ze snel te verhelpen.

Het bedrijf heeft 35 patenten voor het detecteren van bedreigingen en is overtuigd van wat het kan doen voor je netwerkbeveiliging. Het helpt je team ook om te gaan met realtime aanvallen en vermindert het aantal irrelevante waarschuwingen.

2. Darktrace

Darktrace is een AI-gebaseerde cyberbeveiligingstool die altijd actief is en op zoek gaat naar aanvallen. Je kunt het gebruiken om je netwerk, e-mails, apps, cloudservices en meer te bewaken. Het blijft leren en verbeteren nadat je het in je infrastructuur hebt geïmplementeerd.

Het geeft je beveiligingsteams voldoende ademruimte, omdat het verschillende bedreigingen kan detecteren en bestrijden. Deze tool leert wat normaal is in je bedrijf en markeert ongebruikelijke activiteiten.

TweetDelete Voorkomt dat de fouten van Generative AI je geloofwaardigheid schaden

Generatieve AI in cyberbeveiliging heeft een enorm potentieel, dat duidelijk zal worden naarmate deze technologie verbetert. Deze tools verbeteren het besluitvormingsproces van uw beveiligingsteam, terwijl ze minder tijd kwijt zijn aan alledaagse activiteiten.

Hoewel generatieve AI ongelooflijk is, heeft het in zijn huidige staat veel problemen. Deze AI-tweetgeneratoren hebben de neiging om te hallucineren, d.w.z. verkeerde informatie te genereren. Het probleem is dat deze diensten zelfs verkeerde informatie er overtuigend uit kunnen laten zien.

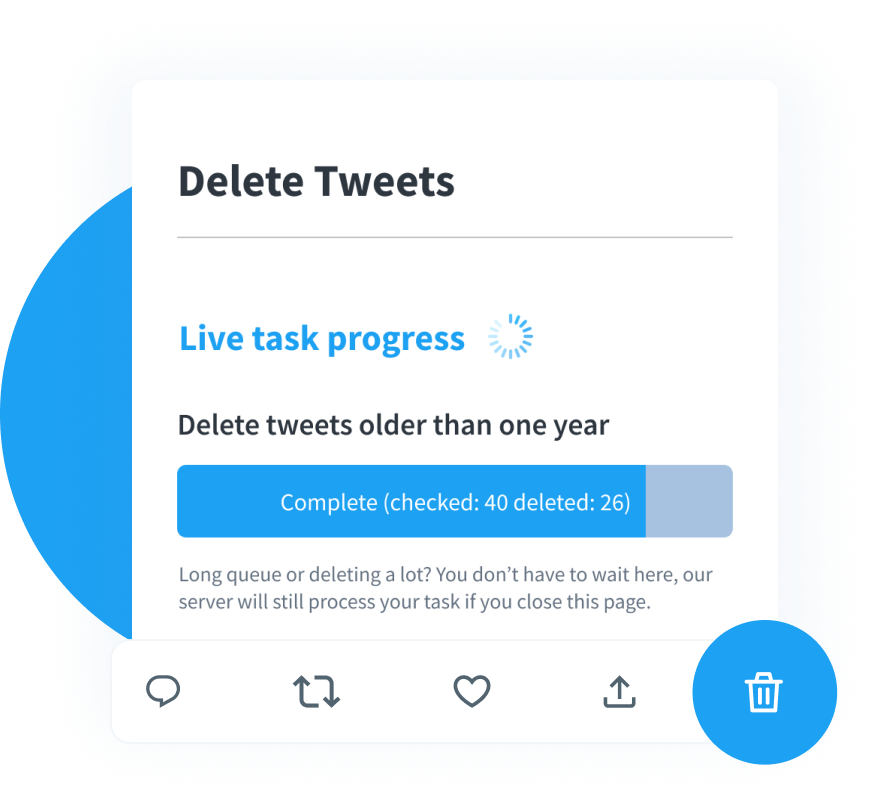

Het publiceren van tweets met dergelijke inhoud kan je geloofwaardigheid schaden, vooral wanneer je jezelf probeert te positioneren als cyberbeveiligingsexpert. Met TweetDelete zal dit echt geen probleem zijn, omdat je de tools hebt om duizenden berichten snel te verwijderen.

Hoe doe je dit? Eerst moet je de aangepaste filter uitvoeren om alle berichten met AI-gegenereerde inhoud te vinden. De volgende stap is om het hulpprogramma voor het massaal verwijderen van tweets te gebruiken om ze van je profielpagina op X te verwijderen.

Wat als je geen tijd hebt om berichten over AI in cyberbeveiliging te verwijderen? In deze situatie is de taak Automatisch verwijderen alles wat je nodig hebt. Het zal je vragen om specifieke trefwoorden en een datumbereik om tweets met AI-inhoud te vinden.

Je kunt ook elk bericht in je profiel verwijderen om het veiliger te maken met deze tool.

Voorkom dat de fouten van generatieve AI je geloofwaardigheid op X, voorheen Twitter, aantasten door TweetDelete vandaag nog te gebruiken!